Instagram 广告投放 A/B 测试怎么做效果更好

说实话,我在刚接触 Instagram 广告投放的时候,也曾经走过不少弯路。那时候觉得只要素材够好看、预算给得足,效果应该不会太差。结果呢?钱烧了不少,转化却寥寥无几。后来慢慢接触了 A/B 测试这个概念,才真正算是找到了投放优化的入门门槛。

A/B 测试听起来好像很高大上,说白了就是「对比实验」——你准备两个或者多个版本的广告,然后让它们在相同条件下竞争,看哪个表现更好。这个方法看起来简单,但真正操作起来需要注意的细节其实非常多。我把自己这几年的实战经验整理了一下,希望能帮到正在摸索的朋友们。

为什么 A/B 测试是 Instagram 广告的必经之路

你可能会想:我经验挺丰富的,直接凭感觉优化不行吗?说实话,还真不太行。原因很简单,我们每个人的直觉都带有偏见,而 A/B 测试能帮你摆脱这种偏见。

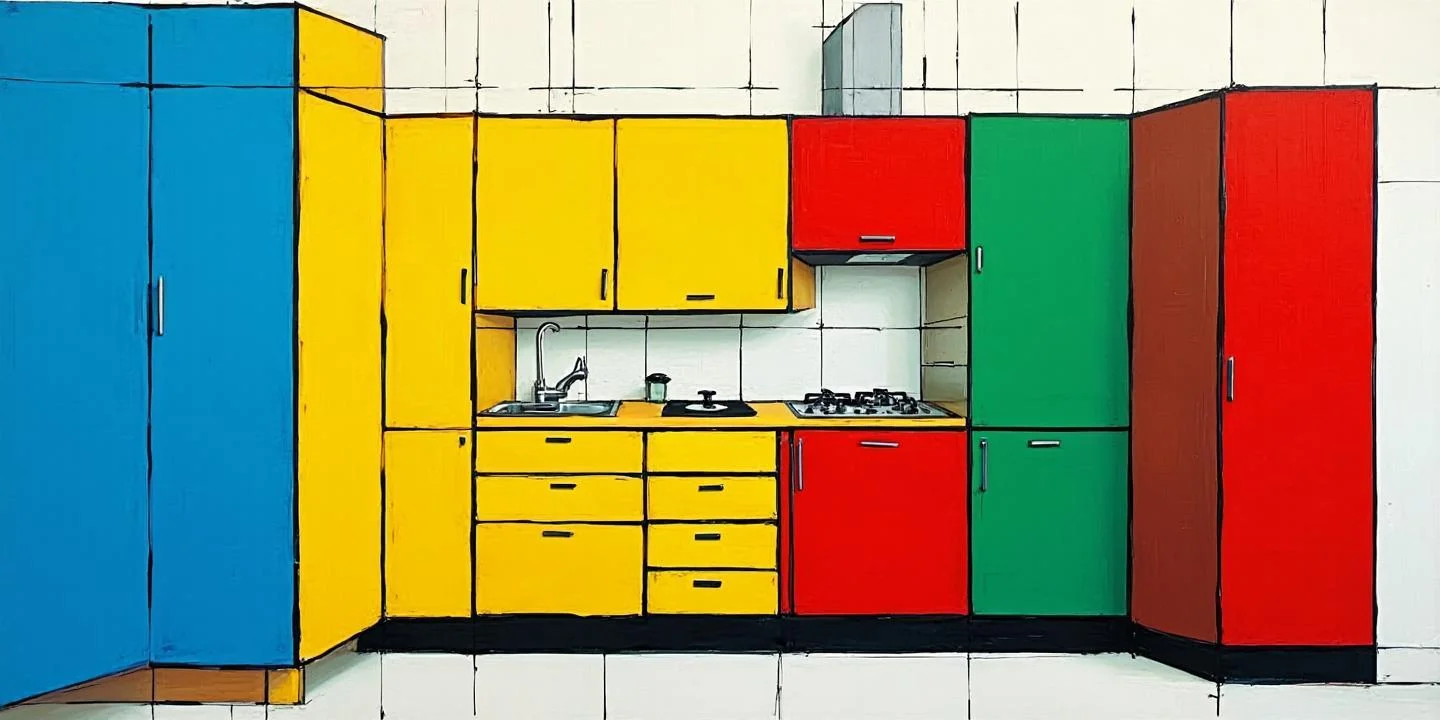

举个很常见的例子。你觉得红色按钮比蓝色按钮更能吸引点击,于是把所有的广告都改成了红色。但实际跑下来数据可能告诉你,用户对蓝色按钮的转化率反而高了 15%。如果没有测试,你可能永远都不会发现这个问题。

更关键的是,Instagram 的算法一直在变,用户群体的审美和习惯也在不断进化。去年有效的策略,今年可能就完全失效了。A/B 测试能让你持续追踪这些变化,而不是凭经验吃老本。

哪些变量最值得测试

这是一个很实际的问题。广告可以调整的变量太多了,如果你每个都测一遍,预算和时间根本不够用。根据我自己的经验,下面这几个维度是优先需要测试的:

素材创意层面

素材是用户第一眼看到的东西,它的表现直接决定了广告有没有可能被点开。这里需要测试的点包括图片和视频的整体风格、色彩的饱和度和冷暖调、文案的语气和长度、还有首帧画面或者封面图的选择。

我个人的习惯是先从「图片 vs 视频」开始测。很多品类视频的效果明显更好,但也有一些场景静态图反而更有效。比如卖那种需要仔细看的精致小物件,静态图反而能让用户看清细节。

文案与CTA按钮

CTA 按钮上的文字真的非常重要。「立即购买」和「去看看有什么区别?」带给用户的心理暗示完全不同。我建议把常见的几种 CTA 表达方式都测试一遍,比如命令式、疑问式、优惠导向式等等。

标题文案的测试也值得关注。但这里有个小技巧:不要一次测试太多变量。比如你同时换了标题和图片,结果转化好了,你根本不知道是哪个因素起的作用。最好每次只改变一个变量。

受众定向

受众这块的测试空间其实非常大。你需要搞清楚你的目标用户到底是哪些人,他们的年龄范围、兴趣爱好、消费能力、地域分布大概是什么样的。

Instagram 提供了很详细的受众定向选项。你可以先从广泛的受众开始测,然后逐步收窄范围。也可以反过来,用相似的受众(Lookalike Audience)来测试,看看你现有客户的特征能不能复制到新用户身上。

版位与投放位置

Instagram 的广告可以出现在信息流、故事页、探索页面甚至 Reels 短视频里。不同版位的用户行为模式差异很大。信息流广告适合比较精致的、品牌感强的内容;故事广告更适合轻松随意、快节奏的创意;Reels 则是现在增长最快的版位,年轻用户占比很高。

测试前的准备工作

很多人一上来就开始建广告,然后跑两天看数据。这种做法其实不够严谨。在开始测试之前,你需要先把下面这几件事做好。

首先,明确你的核心指标到底是什么。是曝光量、点击率、转化率还是最终的 ROI?不同指标可能指向不同的优化方向。如果你追求的是品牌曝光,那应该关注 CPM 和观看完成率;如果你追求的是销售转化,那就要盯着 CPA 和 ROAS。

其次,测试周期要足够长。Instagram 的广告系统需要一定时间学习,一两天的数据根本说明不了问题。我的建议是每个测试至少跑满 7 天,而且要避开大型节假日或者特殊营销活动的影响。

还有一点很关键:样本量要够大。如果你只有几百个展示次数,统计数据几乎没有意义。一般来讲,每个变体至少要有几千次展示,转化类测试则需要更多样本才能得出可靠结论。

常见的测试误区

在说怎么分析结果之前,我想先提醒几个容易踩的坑。这些都是我或者身边朋友亲身经历过的问题。

第一个坑是同时测试太多变量。就像我前面说的,如果你同时改了图片、文案和受众,最后数据出来了,你根本无法归因。正确的做法是每次只改变一个因素,这样才能准确判断哪个因素在起作用。

第二个坑是测试时间太短或者太长。太短数据不准,太长又可能错过优化窗口。我的经验是 7 天是一个比较合适的周期,既能让系统完成学习,又能及时获取足够的数据。

第三个坑是完全依赖自动优化。Facebook 和 Instagram 的广告系统确实很智能,会自动把预算倾斜给效果更好的广告组。但这不意味着你可以完全撒手不管。前期人工干预还是很有必要的,而且要定期检查数据,防止系统跑偏。

如何解读测试数据

数据跑完了,怎么看结果也是一门学问。这里有个概念需要先弄清楚:统计显著性。简单说就是你的测试结果是因为真正的差异导致的,还是只是随机波动。

一般来说,95% 的置信度是一个比较公认的标准。如果你的测试结果没有达到这个标准,那最好继续跑一段时间,或者增加样本量,不要着急下结论。

除了看绝对数字,还要关注趋势。有些广告组前两天表现很差,但后面慢慢起来了;有些则是开头很好,后面持续下滑。这种情况下,不能单纯看平均数据,最好分段来看。

我习惯用表格来记录每次测试的关键数据,这样方便横向对比。下面是一个简单的记录模板:

| 测试项目 | 变体A表现 | 变体B表现 | 胜出方 | 置信度 |

| 图片色彩风格 | CPM 12元,CTR 1.8% | CPM 10元,CTR 2.3% | B(暖色调) | 97% |

| CTA按钮文案 | 转化率 3.2% | 转化率 3.8% | B(行动导向) | 89% |

| 受众年龄段 | CPA 45元 | CPA 38元 | B(25-34岁) | 94% |

这张表能帮你一眼看出哪次测试有结论、哪次还需要继续观察。置信度低于 90% 的测试,我会标记为「待定」,要么加预算继续跑,要么重新设计测试方案。

把测试结果真正用起来

测完了数据不能用起来,等于白测。每一轮测试结束后,我都会做两件事:第一,把胜出的策略沉淀下来,作为后续投放的基础版本;第二,分析失败的变体,找出问题所在,为下一次测试提供灵感。

还有一点很重要的是,A/B 测试不是一劳永逸的事情。市场在变,竞争对手在变,用户口味也在变。这个月有效的策略,下个月可能就需要更新了。建议把 A/B 测试变成一个常态化的工作,每个月至少安排一到两次新的测试。

如果你所在的团队比较大,我建议建立一个内部的测试知识库。把每一次测试的背景、方法、结果和结论都记录下来,这样后面的同事也能参考,避免重复踩坑。

写到最后

说了这么多,其实 A/B 测试的核心思想很简单:不要拍脑袋决策,让数据说话。但真正能做到这一点,并不容易。它需要你有耐心——等得起 7 天的测试周期;有好奇心——不断想尝试新的可能性;还有复盘的习惯——每一次测试无论成功失败都是学习的机会。

如果你之前完全没有做过 A/B 测试,建议从最简单的素材对比开始。选两张图、设置相同的受众和预算,跑一周看看结果。这个过程中,你可能会发现很多自己之前根本没想到的洞察。开始了之后,慢慢地你就会形成一套自己的测试方法论。

投放广告这件事,从来就没有什么包治百病的灵丹妙药。但 A/B 测试能帮你不断逼近最优解,这个过程中积累的认知和经验,才是真正值钱的东西。祝你在测试的路上少踩坑,多出成果。